2. 中国地震台网中心, 北京 100045;

3. 深圳防灾减灾技术研究院, 广东深圳 518003

2. China Earthquake Networks Center, Beijing 100045, China;

3. Shenzhen Academy of Disaster Prevention and Reduction, Shenzhen 518003, Guangdong, China

建筑物损毁信息作为震害信息中较为典型的特征,是进行地震风险评估的重要数据之一。众多研究表明,震中建筑物的损毁和倒塌是造成人员伤亡的最主要因素。房屋倒塌导致民众被掩埋,这也是震后救援的一大难点。相关研究表明,人员伤亡情况与建筑物倒损情况呈函数关系(柳稼航等,2004;王晓青等,2015;袁小祥等,2017;朱达邈等,2021)。因此,灾后进行损毁建筑物的快速评估十分必要,其既可以指导灾后救援工作的开展,也能最大限度地减少各类损失(马玉宏等,2000;陈文凯等,2008;赵琪等,2012;程希萌等,2016)。

对于建筑物的损毁情况调查,目前我国采用的方法多为传统的实地调研、基于高分辨率遥感卫星影像或基于无人机影像等。传统的实地调研方法虽然准确度高,但安全性差且费时费力,不符合地震灾后应急“时间就是生命”的紧迫性(刘耀辉,2020);卫星遥感影像则主要是基于震前、震后影像对建筑物震前、震后的阴影信息或边界角点等进行对比,从而获取建筑物的破损情况,然而,其大多只能针对倒塌的建筑物或建筑物顶面有明显塌陷的情况,并不适用于提取建筑物的表面破损信息,且合适的震前遥感影像较难获取,还要考虑季节和植被遮盖等的问题(杜妍开等,2020;石颉等,2022)。

随着无人机技术的不断发展,无人机倾斜摄影技术解决了传统遥感影像只能从顶面观察的问题,同时其响应迅速,符合灾后救援和评估对于时间的紧迫要求。无人机低空飞行,能够提供高精度的建筑物细节信息,对于低烈度区的建筑物轻微受损信息也可识别,极大地提高了建筑物受损信息的提取精度(李玮玮,2016;李玮玮等,2016;袁小祥等,2017)。然而,目前利用无人机遥感影像对建筑物进行损毁评估时,大多研究还停留在对倒塌建筑物的提取及破损等级的判定,对建筑物表面破损信息有所忽略。随着经济的发展,各类建筑物的坚固性和防震级别得到了很大的提升,除非遇到特大强震或刚好处于震中位置等情形,较少会出现房屋直接倒塌或大面积塌陷的现象,多数情况为从顶面或卫星图像看似完好无损,实际墙壁立面等已出现裂缝或墙体脱落等,这将形成较大的安全隐患,严重时更会导致事故的发生(帅向华等,2018)。

近年来,深度学习的出现与人工智能的飞速发展,为建筑物信息提取提供了更多的可能。随着机器学习和深度卷积网络的不断优化和改进,其展示出了强烈的优越性。目前深度学习技术在遥感影像处理领域已被广泛应用,取得了极大的成就,已有越来越多的学者将其应用于建筑物识别领域(Simonyan et al,2015;于坤,2021;赵若辰等,2021)。

基于以上讨论并根据实际需求,本文提出利用无人机倾斜摄影模型与深度学习网络对建筑物表面破损信息进行自动化提取,以期提高对建筑物表面破损信息检测的效率。以2019年长宁6.0级地震后双河镇无人机航拍影像作为数据源,选用VGG-16模型、DeeplabV3+模型以及面向对象分类方法,对震后建筑物表面破损信息进行提取,并对其结果进行对比分析。研究结果可为灾后建筑物损毁评估提供参考数据,同时也为针对性地部署地震修复重建工作提供数据支撑。

1 基于深度学习的建筑物提取方法目前,建筑物识别可以分为三个方向:目标检测、语义分割和实例分割。针对建筑物提取常用的方法主要有R-CNN、VGG系列网络、U-NET、ResNet以及DeepLab系列等神经网络模型作为基础的算法模型。经过对比分析,除面向对象分类法外,本文另外选用了两种具有代表性的模型来对本文的样本集进行训练,分别为各种图像分类软件最常用的VGG-16模型和语义分割DeepLabV3+模型。通过对这三种方法最终得到的训练结果进行对比分析,选出对提取建筑物表面图像损毁信息较为高效的一种。

1.1 VGG-16模型VGG-16模型是目前市场上大多深度学习提取软件中常用的模型之一,也是VGG网络中运用较为频繁和广泛的模型之一。其网络结构简洁,效果较佳,可在其基础上进行多方面的优化和改进,这也是其广受欢迎的原因之一。并且,训练后的VGG-16模型参数在官网开源,更有利于广大学者分析运用。基于此,众多学者利用其进行其他数据的迁移学习,大大改善了因样本不足而导致的分类精度较低的问题(荆帅军,2019;夏坚等,2022)。

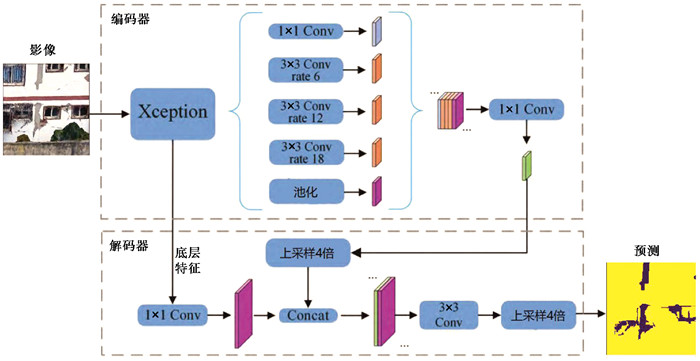

1.2 DeepLabV3+模型DeepLabV3+模型是典型的Dilated FCN模型(图 1)。Deeplab系列网络(Chen et al,2015)最初是基于全卷积神经网络(FCN)改进的,DeeplabV1在CNN网络的基础上引入了Encoder-Decoder结构,利用空洞卷积(Yu et al,2016)方式增大感受野的同时,使用双线性插值和全连接条件随机场(CRF)对网络进行优化;DeeplabV2(Chen et al,2018a)在此基础上加入空洞空间卷积池化金字塔(Atrous Spatial Pyramid Pooling,ASPP);DeeplabV3(Chen et al,2017)提出级联并行的结构,在优化ASPP结构的同时去除了条件随机场;DeeplabV3+(Chen et al,2018b)则在上述的基础上对整体网络进行了优化,并压缩了模型,减少了模型的参数,从而减少了计算量。

|

图 1 DeepLabv3+模型整体架构(据Chen等(2018b)) |

DeeplabV3+模型拥有FCN网络的优势,而且其基于ASPP利用不同的感受野和上采样,从而实现多尺度提取特征,故得到的特征图不仅语义丰富且相对较为精细,可以直接通过插值恢复到原始的分辨率,解决了因多次池化带来的信息丢失、小目标信息无法有效提取等问题。因此,其在针对小目标检测分割上具有较强的优势(程擎等,2021;郝明等,2021)。

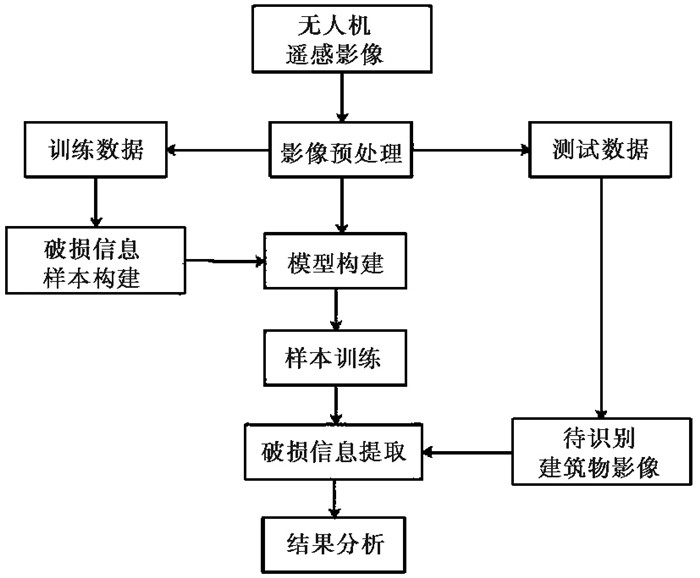

2 研究方法根据无人机倾斜摄影数据的特点和深度学习的关键步骤,本文针对建筑物表面墙体破损信息的提取技术路线如图 2所示,总体分为数据采集及预处理、模型训练两大部分。

|

图 2 建筑物表面破损信息提取技术路线 |

通常情况下,无人机获取的影像为建筑物的顶面影像(袁小祥等,2017),且由于无人机在对建筑物进行采集的过程中飞行高度较低,会遇到视线遮挡等问题,最终采集的影像会出现畸变、倾斜等问题。因此,本文在选取建筑物影像时,选用的是无人机倾斜影像预先生成研究区域的三维模型,再从中获取建筑物表面墙体不同视角的切片图(于坤,2021),这不仅能有效过滤掉一些畸变的建筑物墙体影像,还能从多角度更清晰地获取建筑物表面墙体的破损信息,从而为模型提供高质量的样本。

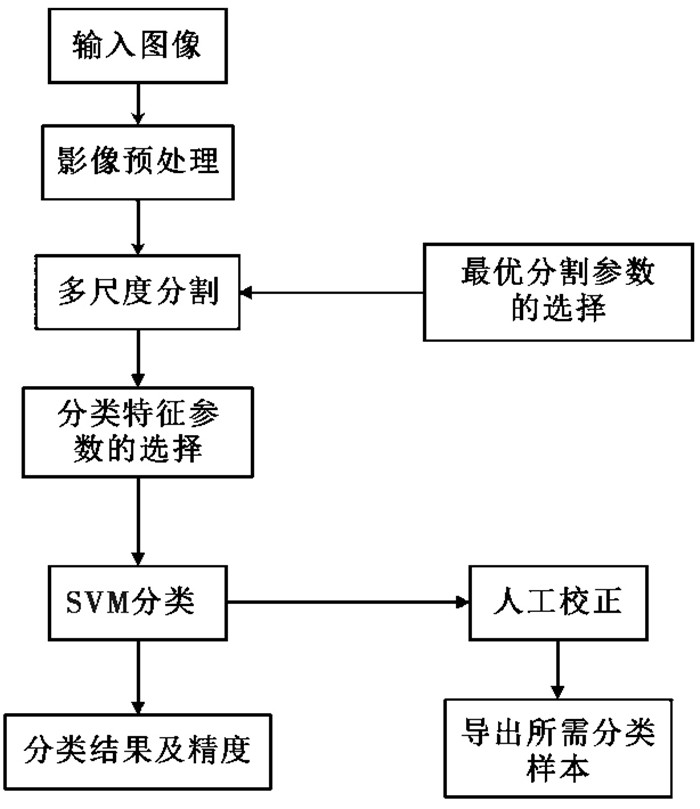

2.2 样本构建面向对象分类方法有别于传统面向像元的分类方法,其并非把每个像元作为分类的最小单元,而是选择将具有“同质均一”的像元合并为一个影像对象,以不同的影像对象作为分类的最小单元,对影像的光谱、形状、空间纹理等信息进行特征分析。该方法不仅突出了影像中语义信息的优势,还避免了同谱异物及同物异谱等分类错误的出现,极大地提高了分类的精度(吴浩霖,2020;李琦,2020)。

基于此,本文首先采用多尺度分割与面向对象分类相结合的方法,基于简译软件对建筑物表面影像进行破损信息的提取,为提高精准度,再辅以人工校正,采用人机交互处理的方法对样本区建筑物表面影像进行破损信息提取,以制作样本数据(图 3)。

|

图 3 面向对象分类流程图 |

为提高提取的精度,要求结合数据影像选择最优的分割尺度。由于影像中裂缝和墙体脱落均较小,且考虑到不同影像内地物类型的差异,通过对比分析不同分割尺度结果,本研究选用分割尺度为50~60,具体数据依不同的影像情况而定(荆帅军等,2019)。

对于分类特征参数的选择,本研究选用影像的光谱、形状和空间纹理等特征参数进行不同信息类别的提取,主要分为破损信息和其他信息。破损信息主要包含裂缝和墙体脱落,部分塌陷等;其他信息则是植被、道路、车辆以及完好的建筑物面等。针对不同影像的差距,本研究选用不同分类特征的不同组合,如亮度、同质度、对比度等。

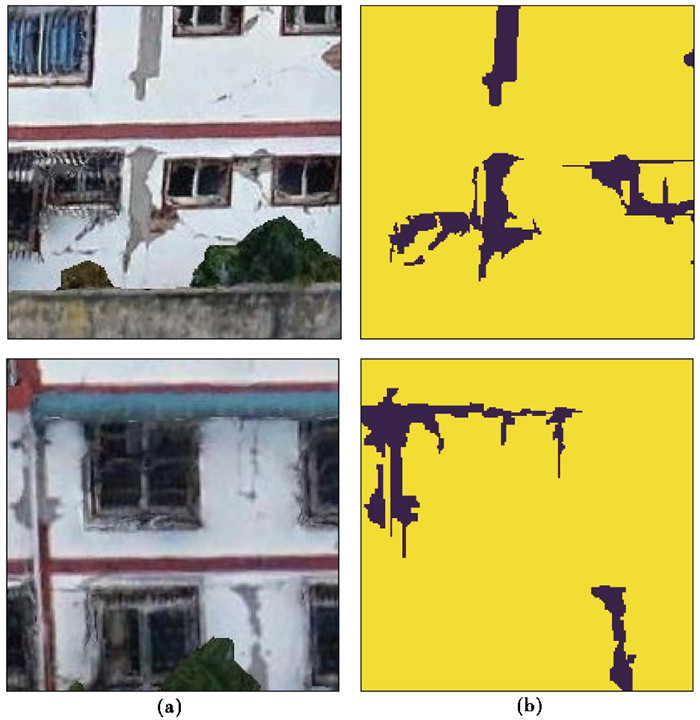

影像分类完成后,辅以人工目视校正,随后以每个被标记分类过的图斑为中心,对其进行裁剪切割,从而生成模型训练所需的样本数据,如图 4所示。由于具有破损信息的样本数量较少,为减少因样本数量不足导致的最终提取精度较低的问题,本研究基于python语言的albumentations第三方库对制作的样本数据进行增强扩增处理,从而丰富样本数据,主要有以下三种方式:旋转或翻转、影像模糊、色彩变换等(梁哲恒等,2021;陈墨等,2021;魏依鹤,2021;黄一昕等,2021;李敬虎等,2022)。

|

图 4 样本图像 注:(a)原始影像;(b)对应的样本标签,其中紫色对应破损信息,黄色对应其他信息。 |

在运用深度学习的过程中,软件开发环境及网络框架是模型训练的基础。分析对比不同的网络框架结构,最终选用基于python环境搭建的pytorch框架,同时利用opencv库对样本数据进行转化以及导入、输出。

关于VGG-16卷积神经网络模型,本研究构建网络结构共有5个block,均由卷积层和最大池化层组成,同时选用3个全连接层作为结尾。除此之外,选用小卷积核代替大的卷积核(图 5)。其中,损失函数为CrossEntropy Loss函数,优化函数采用Adam优化器。

|

图 5 VGG-16模型网络结构(据张林朋等(2023)) |

关于DeeoLabV3+语义分割模型,本研究所用激活层选用Relu激活函数,其可以有效降低网络的复杂性;损失函数采用Dice系数差异函数(Dice loss),并同时使用Adam优化器作为优化函数。

深度学习模型需要大量的数据集进行学习训练,由于本研究自制的样本数据集数量较少,故采用迁移学习的方法,利用公开数据集Image Net对两个模型进行预训练,获取模型参数的初始值。研究表明,即使任务类型差距较大,迁移学习的效果也比随机初始化训练更显著(Yosinski et al,2014)。预训练完成后,再利用破损样本数据集对模型进行训练,根据模型在测试集的测试精度保存最佳模型参数。

2.4 破损信息提取样本构建和模型预训练完成后,针对模型训练精度对模型的参数进行微小调整,寻找最适宜的参数设置,以提高模型训练精度和泛化性。参数设置完善后,将训练好的模型应用于部分切片影像,验证模型的实际应用能力,对比模型之间的实际应用效果,进行讨论分析。

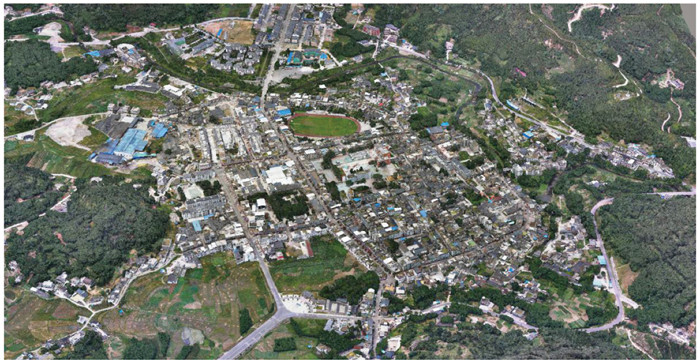

3 实例应用 3.1 实验区概况2019年6月17日22时55分,四川省宜宾市长宁县发生6.0级地震,震中位于28.34°N、104.90°E(处于双河镇内),震源深度16km;地震发生40min后,距离长宁县仅6km的珙县再次发生5.1级余震,四川、重庆、贵州、云南等省份均有震感。长宁6.0级地震造成大量房屋坍塌、基础设施损坏、道路中断,同时引起滑坡、泥石流、崩塌等次生灾害。双河镇位于长宁县南部,正处于此次地震震中位置,综合三维模型和实地照片观察,发现老区房屋受损严重,新区部分房屋墙体也出现了明显的裂缝和墙体脱落(徐志国等,2020;郭志等,2020)。

3.2 模型应用 3.2.1 实验数据选用双河镇无人机低空航拍影像作为实验数据,利用建模软件,经过照片拼接、数据预处理、空中三角形计算、纹理映射等一系列处理后,获得了双河镇灾后倾斜三维模型(图 6)。通过对三维模型进行分析,在三维模型中选取了若干具有明显裂缝、墙体脱落等破损的建筑物墙体切片图,共39幅,再经面向对象分类与人工识别和分类,共标注1015个破损信息图斑,创建原始样本1013个。经过样本数据增强处理后,最终共获取样本数量为71345个。

|

图 6 双河镇灾后倾斜三维模型 |

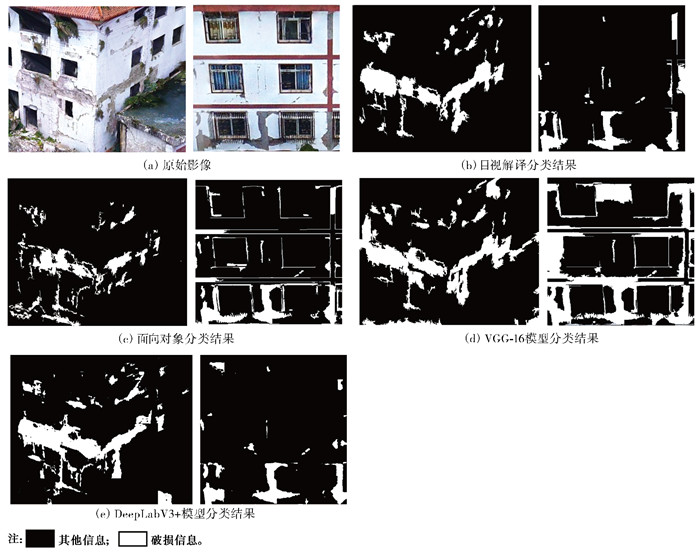

所有模型预训练完成后,选取一部分未参与训练的建筑物表面墙体切片图作为验证集,分别利用训练过的VGG-16模型及DeepLabV3+模型进行建筑物表面破损信息检测提取,与此同时,将人工识别分类验证数据影像所包含的破损信息作为对照,对比分析面向对象分类方法提取结果以及两个模型训练提取的图像结果,提取结果如图 7所示。分析对比提取效果可知,三种方法中,DeepLabV3+模型具有最好的提取效果(图 7(e)),其在细小裂缝识别和提取方面的能力较其他方法更强;而VGG-16模型对于微小的裂缝和颜色相近的地物等,容易出现遗漏和误判的情形,但相较于面向对象分类法,VGG-16模型也具有一定优势;在相邻地物颜色、亮度、对比度等较为接近时,面向对象分类法会出现明显的分类错误,如图 7(c)所示,墙体脱落和地上的废弃堆积物颜色等极为相似,面向对象分类法将其分类为破损信息,在验证集中,这种情况极为常见。

|

图 7 建筑物表面破损信息提取结果对比 |

本文采用精确率(Precision)、召回率(Recall)、总体精度(Overall Accuracy,OA)和交并比(Intersection over Union,IoU)这4个常用指标评价模型的精度,具体定义为

| $ \text { Precision }=\frac{T_p}{T_p+F_p} \times 100 \% $ | (1) |

| $ \text { Recall }=\frac{T_p}{T_p+F_N} \times 100 \% $ | (2) |

| $ \mathrm{OA}=\frac{T_P+T_N}{T_P+F_P+T_N+F_N} \times 100 \% $ | (3) |

| $ \mathrm{IoU}=\frac{\text { Area }_{\mathrm{C} \cap \mathrm{G}}}{\text { Area }_{\mathrm{C} \cup \mathrm{G}}} \times 100 \% $ | (4) |

式中,TP为正确提取出的破损信息图斑个数;FP为错误提取出的破损信息图斑个数;FN为漏检破损信息图斑个数;TN为正确提取出的非破损信息图斑个数;AreaC∩G为模型检测产生的候选区域面积与原标记区域面积的交集;AreaC∪G为模型检测产生的候选区域面积与原标记区域面积的并集(梁哲恒等,2021;程擎等,2021;黄一昕等,2021)。

4 实验结果与分析为比较面向对象分类方法、VGG-16模型和DeepLabV3+模型在建筑物表面破损信息提取方面的优劣性,本文选用8幅建筑物墙体切片图作为测试数据进行对比分析,部分提取结果如图 7所示,提取精度如表 1所示。在实验过程中,三种分类方法使用的样本数据一致,两个神经网络迁移学习数据集一致。由表 1可知,相较于VGG-16模型和面向对象分类方法,DeepLabV3+模型的各项指标均更具优势,其中准确率和召回率高达96.93%和96.85%,总体精度和交并比达到96.89%和94%;而VGG-16模型的召回率较低,仅为76.59%,但准确率和总体精度相较于面向对象分类方法更高,结合图 7分析可知,召回率较低应主要由裂缝等微小破损信息识别率过低导致。由图 7可知,与原始影像(图 7(a))及目视解译分类结果(图 7(b))相比,DeepLabV3+模型对建筑物表面破损信息提取效果明显,可以在很好地分辨墙体破损的同时,较好地保留建筑物墙体的微小破损信息。DeepLabV3+模型不仅在墙体脱落信息的提取上表现优异,在细小裂缝的识别上也具有较高精度。

| 表 1 模型检测提取结果 |

建筑物损坏信息往往被认为是地震灾害最重要的标志,因此,震后第一时间获取到准确的建筑物损毁信息,能够为开展震后应急救援以及灾后重建等提供强有力的技术支持和数据依据。针对无人机遥感影像建筑物表面破损信息提取的问题,本文利用面向对象分类方法以及当前主流的深度学习目标检测网络VGG-16模型和语义分割网络DeepLabV3+模型进行研究,对比分析两种模型相较于面向对象分类方法在建筑物表面破损信息识别方面的应用效果。结果表明,深度学习语义分割网络DeepLabV3+在建筑物表面破损信息的提取上,尤其是墙体裂缝等细小破损信息的提取方面具有较强的可行性。后续可通过不断提升样本数据集的质量和数量,建立震后建筑物受损影像数据集,并通过优化语义分割模型等措施,提升建筑物表面受损信息提取精度。建筑物表面破损信息的精确提取不仅有助于震后应急救援的开展,还适用于桥梁、大坝等设施上裂缝的检测,具有广泛的应用场景。

陈墨、杨沛、陈丽君, 2021, 基于深度学习的建筑表面裂缝缺陷识别, 齐齐哈尔大学学报(自然科学版), 37(5): 57~61, 66. |

陈文凯、何少林、张景发等, 2008, 利用遥感技术提取震害信息方法的研究进展, 西北地震学报, 30(1): 88-93. |

程擎、范满、李彦冬等, 2021, 无人机航拍图像语义分割研究综述, 计算机工程与应用, 57(19): 57-69. |

程希萌、沈占锋、邢廷炎等, 2016, 基于高分遥感影像的地震受灾建筑物提取与倒损情况快速评估, 自然灾害学报, 25(3): 22-31. |

杜妍开、龚丽霞、李强等, 2020, 基于最优分割的高分辨率遥感影像震害建筑物识别技术, 地震学报, 42(6): 760-768. |

郭志、高星、路珍, 2020, 2019年6月17日四川长宁地震重定位及震源机制研究, 地震学报, 42(3): 245-255. |

郝明、田毅、张华等, 2021, 基于DeepLab V3+深度学习的无人机影像建筑物变化检测研究, 现代测绘, 44(2): 1-4. |

黄一昕、方文珊、刘传朋等, 2021, 基于改进U-Net网络的铁路周边无人机影像建筑物提取方法研究, 铁道建筑, 61(11): 158-163. |

荆帅军. 2019. 基于无人机倾斜影像的建筑物震害提取研究. 硕士学位论文. 北京: 中国地震局地震预测研究所.

|

荆帅军、帅向华、甄盟, 2019, 基于无人机倾斜影像的三维建筑物震害精细信息提取, 地震学报, 41(3): 366-376. |

李敬虎、邢前国、郑向阳等, 2022, 基于深度学习的无人机影像夜光藻赤潮提取方法, 计算机应用, 42(9): 2969-2974. |

李琦. 2020. 基于面向对象和深度学习的矿区无人机影像地物提取. 硕士学位论文. 北京: 北京林业大学.

|

李玮玮. 2016. 基于倾斜摄影三维影像的建筑物震害提取研究. 硕士学位论文. 北京: 中国地震局地震预测研究所.

|

李玮玮、帅向华、刘钦, 2016, 基于倾斜摄影三维影像的建筑物震害特征分析, 自然灾害学报, 25(2): 152-158. |

梁哲恒、邓鹏、姜福泉等, 2021, 基于卷积神经网络的无人机影像违章建筑检测应用, 测绘通报, (4): 111-115. |

柳稼航、杨建峰、魏成阶等, 2004, 震害信息遥感获取技术历史、现状和趋势, 自然灾害学报, 13(6): 46-52. |

刘耀辉. 2020. 面向地震风险评估的高分辨率遥感影像建筑物信息提取与研究. 博士学位论文. 北京: 中国地震局地质研究所.

|

马玉宏、谢礼立, 2000, 地震人员伤亡估算方法研究, 地震工程与工程振动, 20(4): 140-147. |

石颉、袁晨翔、丁飞等, 2022, SAR图像建筑物目标检测研究综述, 计算机工程与应用, 58(8): 58-66. |

帅向华、刘钦、甄盟等, 2018, 倾斜摄影技术在云南鲁甸地震现场的应用研究, 震灾防御技术, 13(1): 158-167. |

王晓青、窦爱霞、王龙等, 2015, 2013年四川芦山7.0级地震烈度遥感评估, 地球物理学报, 58(1): 163-171. |

魏依鹤. 2021. 基于深度学习的无人机影像农村建筑物提取研究. 硕士学位论文. 北京: 中国地质大学(北京).

|

吴浩霖. 2020. 基于无人机影像和深度学习技术的建筑物分类和统计——服务于震前预评估的建筑物快速调查. 硕士学位论文. 北京: 中国地震局地质研究所.

|

夏坚、周利君、张伟, 2022, 基于迁移学习与VGG16深度神经网络的建筑物裂缝检测方法, 福建建设科技, (1): 19~22, 60. |

徐志国、梁姗姗、盛书中等, 2020, 2019年四川长宁MS6.0地震序列重定位和震源特征分析, 地震学报, 42(4): 377-391. |

于坤. 2021. 基于深度学习的无人机影像建筑物提取. 硕士学位论文. 邯郸: 河北工程大学.

|

袁小祥、王晓青、丁香等, 2017, 基于无人机影像的九寨沟地震建筑物震害定量评估, 中国地震, 33(4): 582-589. |

赵琪、翟永梅、李铁铮, 2012, 高分辨率遥感图像在城市快速震害预测中的应用研究, 灾害学, 27(2): 72-76. |

赵若辰、王敬东、林思玉等, 2021, 基于卷积神经网络的小型建筑物检测算法, 系统工程与电子技术, 43(11): 3098-3106. |

张林朋、杨红云、钱政等, 2023, 基于改进的VGG16网络和迁移学习的水稻氮素营养诊断, 中国农业大学学报, 28(6): 219-229. |

朱达邈、王东明, 2021, 基于遥感影像的建筑物空间分布方法在地震灾害损失预评估中的应用, 震灾防御技术, 16(3): 510-518. |

Chen L C, Papandreou G, Kokkinos I, et al. 2015. Semantic image segmentation with deep convolutional nets and fully connected CRFs. In: 3rd International Conference on Learning Representations. San Diego: ICLR.

|

Chen L C, Papandreou G, Kokkinos I, et al, 2018a, DeepLab: semantic image segmentation with deep convolutional nets, Atrous convolution, and fully connected CRFs, IEEE Trans Pattern Anal Mach Intell, 40(4): 834-848. |

Chen L C, Papandreou G, Schroff F, et al(2017-12-05). Rethinking Atrous convolution for semantic image segmentation, https://arxiv.org/abs/1706.05587.

|

Chen L C, Zhu Y K, Papandreou G, et al. 2018b. Encoder-decoder with Atrous separable convolution for semantic image segmentation. In: 15th European Conference on Computer Vision. Munich: Springer, 833~851.

|

Simonyan K, Zisserman A. 2015. Very deep convolutional networks for large-scale image recognition. In: 3rd International Conference on Learning Representations. San Diego: ICLR.

|

Yu F, Koltun V. 2016. Multi-scale context aggregation by dilated convolutions. In: 4th International Conference on Learning Representations. San Juan: ICLR.

|

Yosinski J, Clune J, Bengio Y, et al. 2014. How transferable are features in deep neural networks?In: Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal: ACM, 3320~3328.

|

2023, Vol. 39

2023, Vol. 39